“Photos remind us of the people we love — family far away, moments long gone, voices we can’t hear anymore. Our homes are full of smart devices, but none of that bring warmth, presence, or connection.”

Source : Vinabot

“Photos remind us of the people we love — family far away, moments long gone, voices we can’t hear anymore. Our homes are full of smart devices, but none of that bring warmth, presence, or connection.”

Source : Vinabot

“« C’est très difficile de lutter pour les garder dans un environnement académique. L’un de mes doctorants a fait un stage d’été chez Tesla, qui lui a fait une offre avant qu’il ne termine sa thèse », explique-t-il. L’étudiant a décliné mais Tesla est revenu le chercher, une fois son doctorat achevé, en surenchérissant son offre d’embauche, qui avoisinait les 500 000 euros annuels sans les stock-options. Matthieu Cord peut s’amuser à faire la liste de ses thésards partis vers Deepmind, Facebook et Apple surtout : « Les meilleurs partent rapidement en sortie de thèse, ceux qui commencent à publier sont très vite dans les radars des géants du numérique et, après, c’est terminé, on ne les garde plus. » Une fois les jeunes diplômés « absorbés », les liens sont distendus, d’autant que certaines sociétés imposent une forme de loi du silence aux chercheurs et aux salariés.

Certains étudiants du MVA de la promo 2022 s’interrogent désormais aussi sur leur « responsabilité » et leur « rôle sociétal » dans la conception des algorithmes. Un cours de machine learning responsable a été créé à la rentrée 2021 pour répondre à cette aspiration, 60 étudiants avaient manifesté leur intérêt pour une trentaine de places ouvertes. Mathis Clautier refuse de mettre son intelligence au service d’une robotique destinée à la guerre. Il n’est pas sans savoir que Boston Dynamics, une start-up de robotique médiatisée grâce à ses robots humanoïdes, ayant appartenu à Google de 2013 à 2017, avait collaboré avec le programme de recherche de la défense américaine et que l’un de ses robots quadrupèdes « Spot » a fait ses débuts avec l’armée française, en 2021.”

Source : A Saclay, le master qui forme l’élite des spécialistes en intelligence artificielle

“Pour essayer d’affiner son esprit critique, Delphi a donc passé de longs moments à scruter le web, et notamment les questions posées sur les pages Reddit r/AmITheAsshole (que l’on traduirait par « suis-je un trou du cul ? ») et r/Confessions, ou les redditeurs se livrent leurs secrets les moins avouables. Ces situations ont ensuite été soumises aux jugements de sous-traitants, employés grâce à l’Amazon Mechanical Turk, l’outil de microtâche à bas prix mis à disposition par Amazon. De ce processus est sorti une sorte de « guide moral » appelé Commonsense Norm Bank. Cette base de données « compile 1,7 million d’exemples de jugements éthiques de personnes, sur un large éventail de situations quotidiennes. »”

“Google, Microsoft et IBM mettent en avant ces différents cas pour rassurer le grand public et les autorités face à une technologie qui a connu ses casseroles. Entre les possibilités de surveillance de masse ouvertes par la reconnaissance faciale, les biais d’IA racistes, il n’est plus utile de mobiliser la science-fiction pour s’interroger sur l’IA.Les entreprises technologiques l’ont rapidement compris, Microsoft a ouvert son Comité éthique en 2017, Google et IBM en 2018. Insuffisant pour les associations de défenses des droits. Selon Jascha Galaski, chargé de plaidoyer pour l’Union des libertés civiles pour l’Europe, les comités éthiques manquent encore d’indépendance et de transparence. Il estime « utopique » qu’ils finissent par le devenir d’eux-mêmes.”

Source : Au nom de l’éthique Google, IBM et Microsoft, ont renoncé à des projets IA

“These early results are encouraging, and we look forward to sharing more soon, but sensibleness and specificity aren’t the only qualities we’re looking for in models like LaMDA. We’re also exploring dimensions like “interestingness,” by assessing whether responses are insightful, unexpected or witty. Being Google, we also care a lot about factuality (that is, whether LaMDA sticks to facts, something language models often struggle with), and are investigating ways to ensure LaMDA’s responses aren’t just compelling but correct. But the most important question we ask ourselves when it comes to our technologies is whether they adhere to our AI Principles. Language might be one of humanity’s greatest tools, but like all tools it can be misused. Models trained on language can propagate that misuse — for instance, by internalizing biases, mirroring hateful speech, or replicating misleading information. And even when the language it’s trained on is carefully vetted, the model itself can still be put to ill use. ”

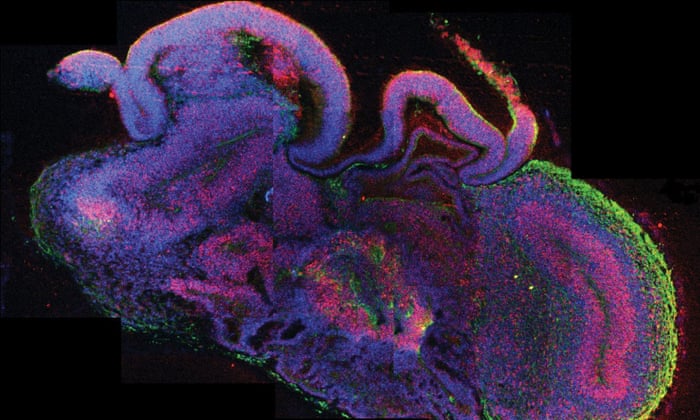

“On Monday, researchers will tell the world’s largest annual meeting of neuroscientists that some scientists working on organoids are “perilously close” to crossing the ethical line, while others may already have done so by creating sentient lumps of brain in the lab. “If there’s even a possibility of the organoid being sentient, we could be crossing that line,” said Elan Ohayon, the director of the Green Neuroscience Laboratory in San Diego, California. “We don’t want people doing research where there is potential for something to suffer.””

Source : Scientists ‘may have crossed ethical line’ in growing human brains | Science | The Guardian

Le choix des Français ? Vraiment ?

“The Moral Machine Experiment, une étude réalisée par des chercheurs du MIT, a compilé les choix moraux de 2,3 millions de participants issus de 233 pays et territoires. Elle révèle qu’il n’y a pas vraiment de code moral universel, et que la France se distingue souvent de ses voisins.”

“Haha. C’est vrai, j’ai le permis mais je n’ai pas pris le volant depuis quinze ans. Je suis trop dangereux et ma famille me l’interdit. Je suis le client parfait pour les voitures autonomes, qui quel que soit leur niveau de sécurité, conduiront toujours mieux que moi.”

Source : Jean-François Bonnefon trace sa route en toute autonomie

«Dans les playlists de Spotify, plus de R. Kelly ni de XXXTentacion. Si les chansons des deux artistes restent disponibles sur la plateforme d’écoute de musique en ligne, elles n’y sont plus mises en avant dans les sélections – des listes générées automatiquement en fonction des goûts des utilisateurs, ou créées par thématique. Une décision liée aux accusations qui pèsent sur les chanteurs, soupçonnés de violences sexuelles pour le premier, et de violences conjugales pour le second».

« Pour la première fois, Spotify a fait un aveu. Elle a reconnu qu’elle avait un statut de média, et non pas d’hébergeur. Elle ne se contentera plus seulement de réagir aux musiques ou artistes problématiques qui lui sont signalés. Désormais, elle va agir en amont, éditorialiser ses contenus, remplacer la loi par la morale » – Sophian Fanen.

Source : Spotify va pénaliser les artistes aux comportements jugés problématiques

«Convoquer des spéculations sur des formes d’IA qui n’existent pas encore et n’existeront probablement jamais, pour terrifier et mobiliser les foules relève plus de la religion que de la science. Ces invitations à embrasser une forme de futur inévitable qu’on martèle pour se persuader qu’il va advenir me cassent les pieds» – Hubert Guillaud.

© 2026 no-Flux

Theme by Anders Noren — Up ↑