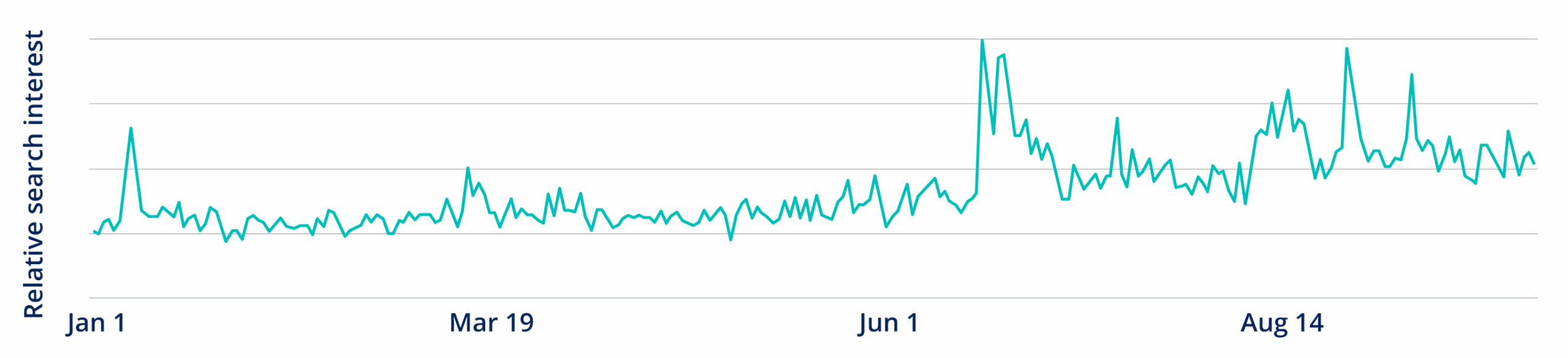

“Russian authorities blocked access to Snapchat and imposed restrictions on Apple’s video calling service, FaceTime, the latest step in an effort to tighten control over the internet and communications online, according to state-run news agencies and the country’s communications regulator […].

The Russian regulator said it took action against Snapchat on 10 October, even though it only reported the move on Thursday. The moves follow restrictions against Google’s YouTube, Meta’s WhatsApp and Instagram, and the Telegram messaging service, itself founded by a Russian-born man, that came in the wake of Vladimir Putin’s invasion of Ukraine in 2022.”

Source : Russia blocks Snapchat and restricts Apple’s FaceTime, state officials say | Snapchat | The Guardian